(Vía ScienceNode) La turbulencia está presente en la mayoría de los fluidos, como las corrientes oceánicas, el aire que fluye alrededor de las alas de los aviones, la sangre de nuestras arterias o el humo de las chimeneas. Dado que la turbulencia es un fenómeno tan generalizado, su estudio tiene numerosas aplicaciones industriales y ambientales. Por ejemplo, los investigadores realizan modelos de turbulencia para mejorar el diseño de vehículos, diagnosticar aterosclerosis, construir puentes más seguros y reducir la contaminación del aire.

La turbulencia está causada por el exceso de energía que no puede ser absorbida por la viscosidad de un fluido y es por naturaleza irregular y difícil de predecir. La velocidad del fluido en cualquier punto fluctúa constantemente tanto en magnitud como en dirección, y esto ha planteado un desafío permanente para los investigadores que trabajan en esta disciplina. Las ecuaciones que pretenden simular todos los cambios del fluido en movimiento en el tiempo, el espacio y a diferentes escalas, dan como resultado demasiados datos. Incluso hoy en día, una simulación por ordenador podría dar cabida a solo una pequeña sección del flujo turbulento.

Los investigadores utilizan modelos para completar los datos en las simulaciones de turbulencia. Sin embargo, si estos modelos son inexactos darán como resultado una simulación incorrecta que no representará el flujo que se está intentando simular. Un trabajo publicado recientemente en la revista Science por el grupo en Dinámica de Fluidos de la Universidad Politécnica de Madrid (UPM), ha aportado nuevos resultados que servirán para reducir las diferencias entre los flujos simulados y los flujos reales. “Una de las fuentes principales de discrepancia entre los flujos simulados por ordenador y el flujo alrededor de un avión real es el bajo rendimiento de los modelos”, afirma José I. Cardesa, primer autor del trabajo. El grupo en Dinámica de Fluidos de la UPM está liderado por Javier Jiménez y estudian los modelos de turbulencia gracias a los recursos de supercomputación de la RES desde 2006.

La simplicidad subyacente en el movimiento turbulento

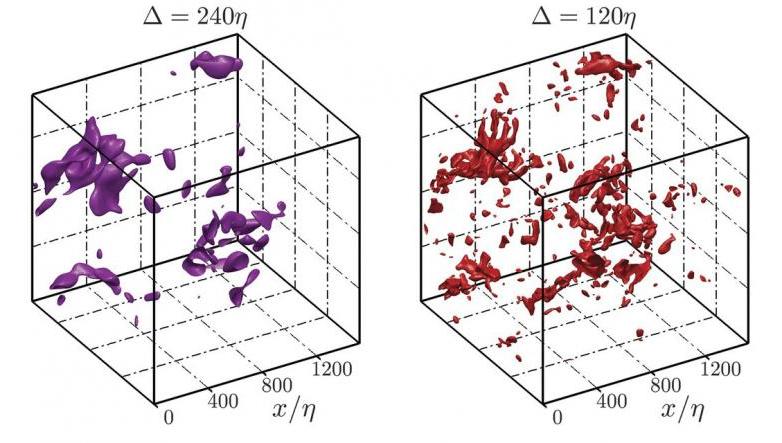

En 1940, el matemático Andrey Kolmogorv propuso que la turbulencia tiene lugar en cascada. Un flujo turbulento contiene remolinos de muchos tamaños diferentes. Según Kolmogorov, la energía se transfiere de los remolinos grandes a los más pequeños, que son también más numerosos, en lugar de dispersarse hacia distancias más alejadas. Pero, según afirma Cardesa, el comportamiento caótico de un fluido hace que sea difícil observar cualquier tendencia a simple vista.

Con el objetivo de monitorizar remolinos individuales y determinar si existe un comportamiento recurrente en la forma en que se expande la turbulencia, los investigadores del grupo de Dinámica de Fluidos simularon un flujo turbulento utilizando el clúster MinoTauro en el Barcelona Supercomputing Center.

El código se ejecutó en paralelo en tarjetas NVIDIA Tesla M2090, utilizando un código híbrido CUDA-MPI desarrollado por Alberto Vela-Martín. Los cálculos se ejecutaron durante tres meses y dieron como resultado más de 100 TB de datos comprimidos.

El análisis de los datos de simulación almacenados fue progresando lentamente al principio, hasta que los investigadores ajustaron el código para que pudiera caber en un solo nodo del clúster con 48 GB de RAM por nodo. De esta forma, podían ejecutar el proceso de forma independiente en doce nodos diferentes y pudieron completar la tarea en tan solo un mes.

Los resultados obtenidos validaron la teoría de Kolmogorov, revelando que el movimiento aparentemente aleatorio de los fluidos turbulentos se puede explicar por un mecanismo subyacente simple. El siguiente paso podría ser intentar comprender la causa de la tendencia detectada o implementar los nuevos conocimientos en el software utilizado en la dinámica de fluidos computacional (CFD).

El trabajo publicado recientemente ha sido posible gracias a los avances en la velocidad de computación y la capacidad de almacenamiento. Cardesa señala que su trabajo habría sido posible hace unos diez años, pero habría supuesto un gasto mucho mayor y un esfuerzo computacional “heroico”. “El coste reducido de la tecnología nos ha permitido lidiar con estos conjuntos de datos. Esto es extremadamente útil para poder hacer investigación fundamental y poner todos nuestros esfuerzos en resolver el problema.”

Referencia

Cardesa, J.I., Vela-Martín, A. and Jiménez, J., 2017. The turbulent cascade in five dimensions. Science, p.eaan7933. DOI: 10.1126/science.aan7933